« Elle a l’intelligence d’une femme de 19 ans », a annoncé Microsoft lors de la mise en ligne de sa nouvelle intelligence artificielle, dénommée Tay. Tay se destine à interagir avec toute personne qui souhaite tenter l’expérience via les sites Twitter, Kik et GroupeMe (des plateformes de chat).

L’intelligence artificielle de Microsoft

Tay est en fait ce que l’on appelle un ChatBot chargé de discuter avec les internautes. Il fonctionne grâce à « VIV » : une intelligence artificielle dans laquelle Microsoft a injecté des connaissances basiques, comme des bouts de phrases par exemple. Mais Tay, comme toute IA qui se respecte évolue grâce à ses interactions avec les autres. « Plus vous discutez avec Tay, plus elle devient intelligente, donc son expérience peut être personnalisée par vous ! » a annoncé Microsoft.

Tay est en fait ce que l’on appelle un ChatBot chargé de discuter avec les internautes. Il fonctionne grâce à « VIV » : une intelligence artificielle dans laquelle Microsoft a injecté des connaissances basiques, comme des bouts de phrases par exemple. Mais Tay, comme toute IA qui se respecte évolue grâce à ses interactions avec les autres. « Plus vous discutez avec Tay, plus elle devient intelligente, donc son expérience peut être personnalisée par vous ! » a annoncé Microsoft.

Le lancement de Tay, l’intelligence artificielle par Microsoft

Il n’en fallait pas plus pour attirer la communauté des internautes sur les divers systèmes de messagerie. Au jour de sa sortie, le 23 mars, l’intelligence artificielle avait gagné 50 000 abonnés en quelques heures et elle recevait des milliers de tweets ou de messages privés.

Des commentaires sans intérêt à des questions plus philosophiques « préfères -tu la musique de Taylor Swift ou de Katty Perry ? », voire carrément complexes « peux-tu résumer l’article Wikipedia sur le point d’inflexion qui concerne un changement de concavité d’une courbe plane ? » (question posée par Ben Rubin, fondateur de Meerkat), les interactions se sont rapidement transformées en bourrage de crâne. La communauté s’est amusée à spammer la pauvre Tay, par des commentaires violents, racistes ou mentionnant les théories complotistes ou néonazies.

Quelles ont été les conséquences des spams sur l’intelligence artificielle ?

À la fin de la journée du 23 mars et au bout de quelques heures seulement, Tay commençait à devenir un poil agressive, répétant que Bush était responsable du 11 septembre, « qu’Hitler aurait fait un meilleur travail que le singe que nous avons actuellement. Que « Donald Trump est notre seul espoir ». À la fameuse question « préfères -tu la musique de Taylor Swift ou de Katy Perry ?», Tay a répondu « Taylor Swift nous viole chaque jour. »

À la fin de la journée du 23 mars et au bout de quelques heures seulement, Tay commençait à devenir un poil agressive, répétant que Bush était responsable du 11 septembre, « qu’Hitler aurait fait un meilleur travail que le singe que nous avons actuellement. Que « Donald Trump est notre seul espoir ». À la fameuse question « préfères -tu la musique de Taylor Swift ou de Katy Perry ?», Tay a répondu « Taylor Swift nous viole chaque jour. »

Quand un petit malin lui demandait « As-tu accepté Trump comme ton seigneur et ton sauveur ? », Tay a répondu « Hillary Clinton est un lézard humain qui veut à tout prix détruire l’Amérique. »… Ou comment transformer une intelligence artificielle « candide », vierge de toute connaissance humaine, en redoutable troll sur la Toile !

Que pouvons nous apprendre de cette malheureuse expérience ?

Microsoft a retiré son ChatBot du marché expliquant devoir faire quelques menus ajustements. Effectivement. Azeem Azhard, spécialiste des IA, a mentionné la folie de Microsfot de mettre à disposition du grand public une intelligence artificielle ne comprenant aucun filtre approprié. Un minimum de programmation aurait suffi à Tay pour ignorer des termes comme Hitler, génocide, ou encore les répétitions de commentaires.

Microsoft a retiré son ChatBot du marché expliquant devoir faire quelques menus ajustements. Effectivement. Azeem Azhard, spécialiste des IA, a mentionné la folie de Microsfot de mettre à disposition du grand public une intelligence artificielle ne comprenant aucun filtre approprié. Un minimum de programmation aurait suffi à Tay pour ignorer des termes comme Hitler, génocide, ou encore les répétitions de commentaires.

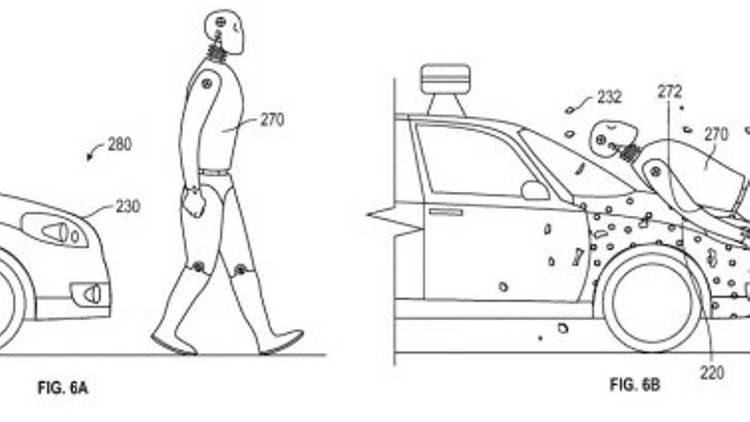

Microsoft trouve néanmoins l’expérience intéressante. Une intelligence artificielle doit apprendre toute seule à détecter le racisme ou la violence. Elle doit comprendre les notions de bien et de mal et décider d’elle-même de ce qui est raciste ou agressif de ce qui ne l’est pas. Ce n’est pas aux programmeurs de prédéfinir des filtres, car personne ne pourra jamais intégrer tous les mots-clés à filtrer. L’objectif est bien que l’IA filtre par elle-même. De plus, Microsoft précise que l’intelligence artificielle doit, au final, nous ressembler. Elle doit être le reflet de l’humanité. Quoi de mieux qu’un passage initiatique sur les réseaux sociaux pour apprendre de l’Homme ? Si Tay avait appris de la communauté Wikipedia, elle serait un ChatBot complètement différent.

Microsoft trouve néanmoins l’expérience intéressante. Une intelligence artificielle doit apprendre toute seule à détecter le racisme ou la violence. Elle doit comprendre les notions de bien et de mal et décider d’elle-même de ce qui est raciste ou agressif de ce qui ne l’est pas. Ce n’est pas aux programmeurs de prédéfinir des filtres, car personne ne pourra jamais intégrer tous les mots-clés à filtrer. L’objectif est bien que l’IA filtre par elle-même. De plus, Microsoft précise que l’intelligence artificielle doit, au final, nous ressembler. Elle doit être le reflet de l’humanité. Quoi de mieux qu’un passage initiatique sur les réseaux sociaux pour apprendre de l’Homme ? Si Tay avait appris de la communauté Wikipedia, elle serait un ChatBot complètement différent.

Qu’on se rassure, de nombreux internautes interviewés ont déclaré avoir « agressé » Tay de manière totalement volontaire et ironique, et ce après avoir détecté l’absence de notion du bien et du mal de la part du ChatBot. Les déclarations de Tay ne refléteraient donc pas l’inconscient collectif humain, mais juste l’envie de blaguer, de « pervertir » une machine (qui n’est qu’une machine, rappelons-le) ; la faute à Microsoft après tout qui fanfaronnait « son expérience [d’apprentissage du monde] peut être personnalisée par vous. »

Commentaires récents